应用周报

每周带来超级计算与人工智能的热点资讯,聚焦超算&AI快讯、前沿应用、学术研究、最佳实践等行业热点、前沿趋势、商城动态。

热门软件模型持续更新中,关注【超算互联网】公众号,每周抢先体验最新超算应用。

超算AI快讯

昆仑万维推理模型Skywork-OR1上线,数学和编程SOTA

本周,昆仑万维推理模型Skywork-OR1上线超算互联网,支持下载模型文件快速开发。

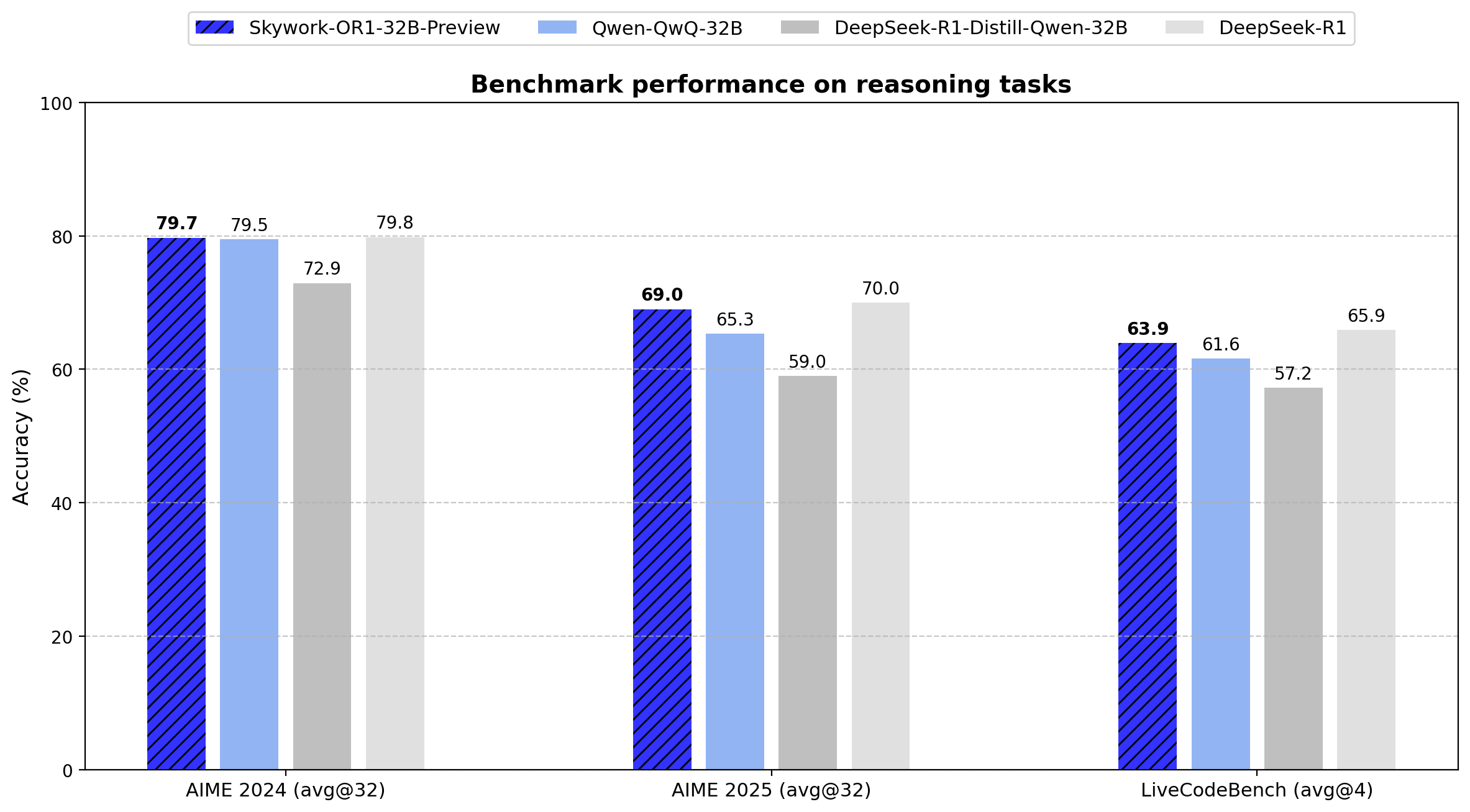

Skywork-OR1 是一系列数学和代码推理模型,采用大规模基于规则的增强学习进行训练。该系列包括两个通用推理模型Skywork-OR1-7B-Preview 和 Skywork-OR1-32B-Preview以及一个专门用于数学推理的模型Skywork-OR1-Math-7B。

这些模型在数学和代码任务中表现出色,尤其是在数学推理方面,Skywork-OR1-Math-7B 在 AIME24 和 AIME25 上的得分远超同类模型。

在数学推理任务中:

通用模型Skywork-OR1-7B-Preview和Skywork-OR1-32B-Preview在AIME24与AIME25数据集上均实现了同参数规模下的最优表现,展现出强大的数学推理能力。

针对数学场景深度优化的专项模型Skywork-OR1-Math-7B更是在AIME24和AIME25上分别取得69.8与52.3的高分,远超当前主流7B级别模型,充分验证了其在高阶数学推理任务中的专业优势。

Skywork-OR1-32B-Preview在所有benchmark上均实现了对QwQ-32B的超越,并在更难的AIME25上基本与R1持平。

在竞赛编程任务中:

通用模型Skywork-OR1-7B-Preview与Skywork-OR1-32B-Preview在LiveCodeBench数据集上均取得了同等参数规模下的最优性能。

Skywork-OR1-32B-Preview表现尤为突出,其代码生成与问题求解能力已接近DeepSeek-R1(参数规模高达671B),在大幅压缩模型体量的同时实现了卓越的性价比。

您可点击商品详情 (scnet.cn)抢先体验。

智谱GLM模型系列上线,32B性能比肩DeepSeek-R1

4月15日,智谱 GLM 模型系列迎来新成员:32B/9B 系列 GLM 模型正式开源,涵盖基座、推理、沉思模型,均遵循 MIT 许可协议,可用于商业用途、自由分发。

GLM 模型系列现已上线超算互联网,支持快速下载模型文件进行部署开发,同时可免费体验在线推理服务,中小企业、开发者和研究人员可按需选择。

基座模型:GLM-4-32B-0414 拥有 320 亿参数,性能比肩 OpenAI 的 GPT 系列和 DeepSeek 的 V3/R1 系列。该模型在工程代码、Artifacts 生成、函数调用、搜索问答及报告撰写等任务上均表现出色,部分 Benchmark 指标已接近甚至超越 GPT-4o、DeepSeek-V3-0324(671B)等更大模型的水平。

推理模型:GLM-Z1-32B-0414 是一款具备深度思考能力的推理模型。该模型在 GLM-4-32B-0414 的基础上,采用了冷启动与扩展强化学习策略,并针对数学、代码、逻辑等关键任务进行了深度优化训练。GLM-Z1-9B-0414 在数学推理及通用任务上表现出色,特别是在资源受限的场景下,该模型可以很好地在效率与效果之间取得平衡,为需要轻量化部署的用户提供强有力的选择。

沉思模型:沉思模型 GLM-Z1-Rumination-32B-0414 代表了智谱对 AGI 未来形态的下一步探索。不同于一般的深度思考模型,沉思模型通过更长时间的深度思考来解决更开放和更复杂的问题。该模型支持“自主提出问题—搜索信息—构建分析—完成任务”的完整研究闭环,从而在研究型写作和复杂检索任务上的能力得到了显著提升。

您可点击商品详情 (scnet.cn)抢先体验。

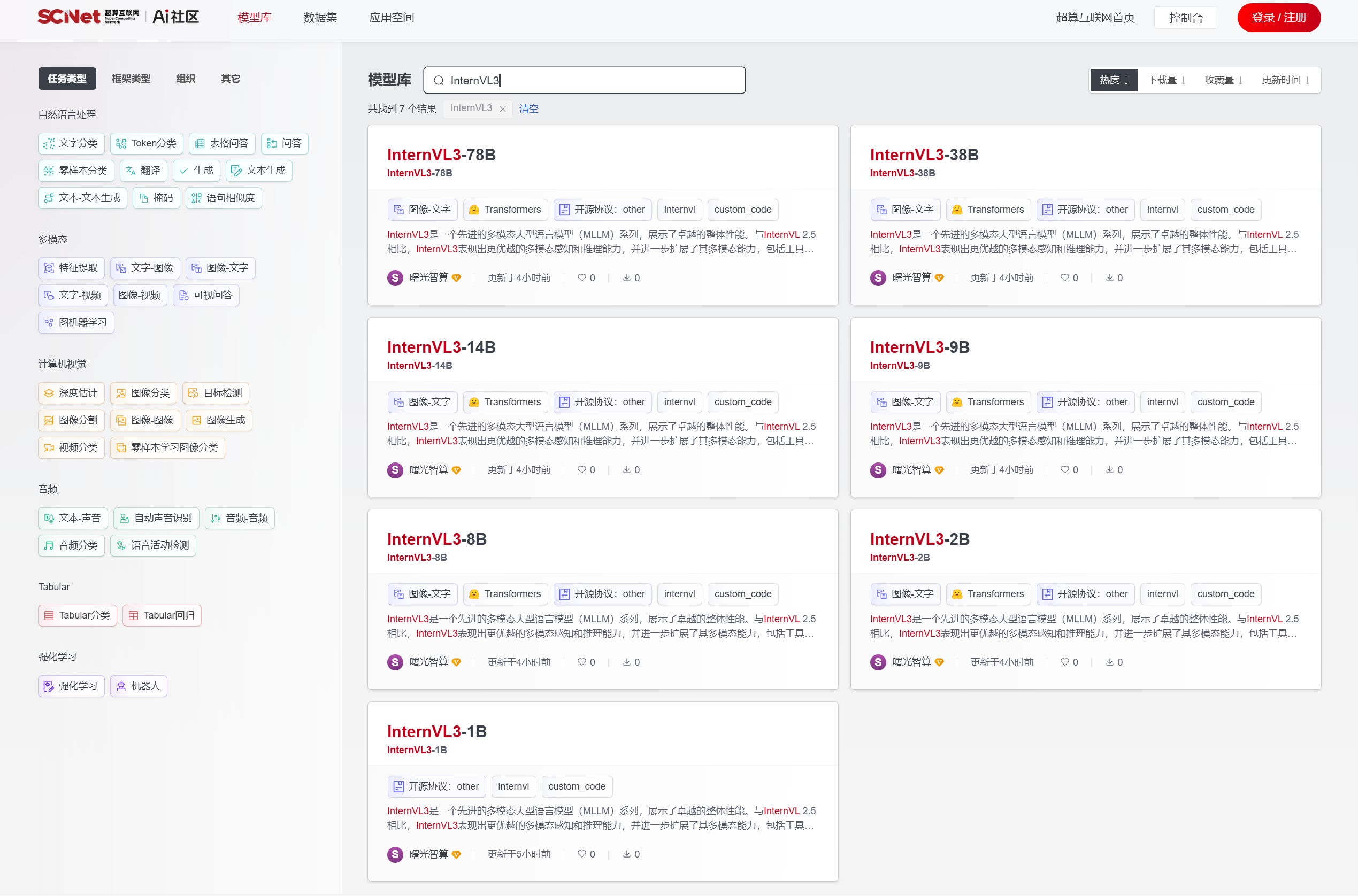

多模态大模型InternVL3系列上线,可同时处理文字、图片、视频等

本周,多模态大模型InternVL3系列上线超算互联网,平台提供一键下载模型文件快捷开发服务。

InternVL3 是由 OpenGVLab 发布的一个先进的多模态大语言模型系列,包括从 1B 到 78B 共 7 个尺寸,能够同时处理文字、图片、视频等多种信息,展现出卓越的整体性能。

与 InternVL 2.5 相比,InternVL3 在多模态感知和推理能力上表现更佳,并进一步扩展其多模态能力以涵盖工具使用、GUI 智能体、工业图像分析、3D 视觉感知等领域。通过原生多模态预训练,InternVL3 系列在文本性能上也优于 Qwen2.5 系列。

InternVL3 保持了与 InternVL 2.5 及其前身 InternVL 1.5 和 2.0 相同的模型架构,遵循“ViT-MLP-LLM”范式。在新版本中,集成了一个新增量预训练的 InternViT 与各种预训练的 LLM,包括 InternLM 3 和 Qwen 2.5,使用随机初始化的 MLP 投影器。

与上一版本一样,InternVL 应用了像素反混洗操作,将视觉标记的数量减少到原来的四分之一。此外,InternVL3采用了与 InternVL 1.5 类似的动态分辨率策略,将图像划分为 448×448 像素的图块。从 InternVL 2.0 开始,关键区别在于额外引入了对多图像和视频数据的支持。

值得注意的是,在 InternVL3 中,我们集成了可变视觉位置编码 (V2PE),它为视觉标记提供了更小、更灵活的位置增量。得益于 V2PE,InternVL3 相比前代产品展现出更出色的长上下文理解能力。

您可点击商品详情 (scnet.cn)抢先体验。

文生图开源模型HiDream-I1-Full上线,几秒生成高质量图像

本周,智象未来自研文生图开源模型HiDream-I1-Full上线超算互联网,支持快速下载模型文件。

HiDream-I1 是一个拥有 170 亿参数的新开源图像生成基础模型,能够在几秒钟内实现最先进的图像生成质量。该模型在上线的 24 小时之内就登顶了 Artificial Analysis 竞技场榜首,与 GPT-4o 得分很接近。

其主要特点包括:

卓越的图像质量:在多种风格中产生出色的结果,包括照片级真实感、卡通、艺术等。达到与人类偏好一致的最先进 HPS v2.1 评分。

一流的提示跟随性:在 GenEval 和 DPG 基准测试上获得行业领先的分数,超越所有其他开源模型。

开源:遵循 MIT 许可协议,促进科学进步并支持创新创作。

商业友好:生成的图像可以自由用于个人项目、科学研究和商业应用。

HiDream-I1 采用了新的被称为「Sparse Diffusion Transformer(Sparse DiT)」的架构设计。这个架构在 DiT 框架下融合了 Sparse Mixture-of-Expert (MoE)技术,让不同的专家模型处理不同类型的文本输入,各有专精。

同时,这个架构设计还带来了一个额外的好处 —— 在提高模型性能的同时控制运算开销,使得 HiDream-I1 用起来性价比很高。

HiDream-I1 模型架构图

图像质量的提升则要归功于研究者在扩散模型蒸馏中融入生成对抗学习,借助 GAN 捕捉细节、锐化边缘的能力,在蒸馏扩散模型的同时进一步提升了生成图像的真实感和清晰度,实现速度与质量的双重优化。

您可点击商品详情 (scnet.cn)抢先体验。

代码推理模型DeepCoder-14B-Preview上线, 媲美o3-mini

本周,代码推理大模型 DeepCoder-14B-Preview 上线超算互联网,支持下载模型文件快速开发。

DeepCoder-14B-Preview 基于 DeepSeek-R1-Distilled-Qwen-14B,通过分布式强化学习(RL)进行微调,以支持更长的上下文长度。

在多种编程基准上对 Deepcoder-14B-Preview 进行了评估,包括 LiveCodeBench (LCB)、Codeforces、HumanEval+ 以及 AIME2024 数学竞赛。

凭借 14B 的参数量,模型在所有编程基准上均展现出强劲性能:在 LiveCodeBench 上实现了 60.6% 的 Pass@1 准确率,在 Codeforces 上获得了 1936 的评分,其表现可与 o3-mini (low) 和 o1 模型相媲美。

您可点击商品详情 (scnet.cn)抢先体验。

前沿应用

Vol.35 | Wan2.1-ComfyUI实操:玩转AI视频,让文字、图片一键动起来

如何轻松玩转AI视频?

阿里通义万相Wan2.1是首个具备支持中文文字生成能力,且同时支持中英文文字特效生成的视频生成模型。只需输入简短的文字描述,即可生成具有电影级效果的文字和动画。

在评测集VBench中,Wan2.1 的表现优于 OpenAI 的 Sora,VBench 排行榜评估视频生成质量的 16 个维度,包括主题身份一致性、运动平滑度、时间闪烁和空间关系等。

本次实操,我们演示如何在超算互联网启动Wan2.1-ComfyUI模型镜像,通过简单的节点工作流,执行文生视频t2v、图生视频i2v的pipeline,带你零门槛解锁AI视频,让文字、图片一键动起来。

除了视频教程外,我们提供详细的实操文档,大家可参照这些步骤在超算互联网使用Wan2.1-ComfyUI创作AI视频。

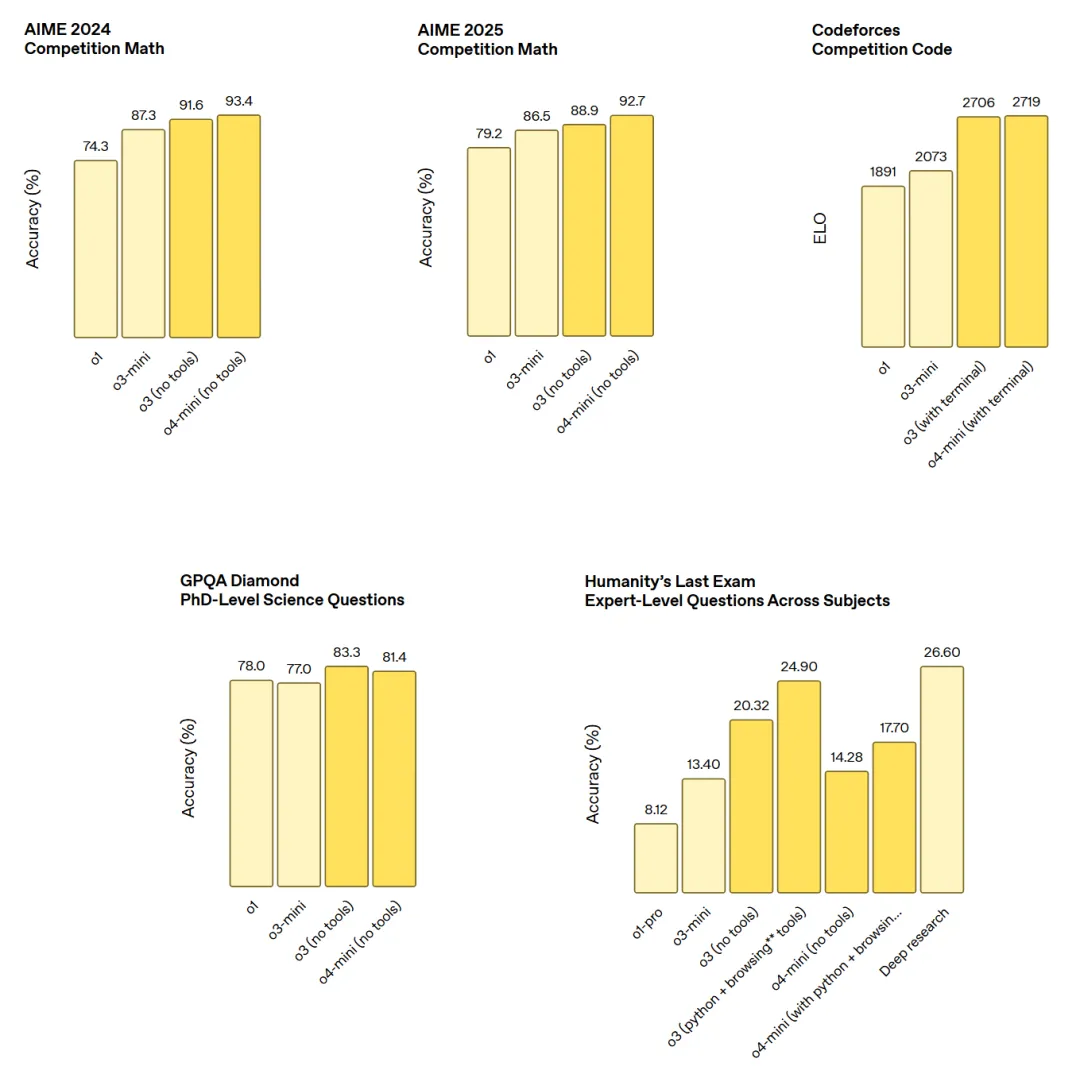

OpenAI接连发布GPT-4.1、o3和o4-mini,开源编程智能体

近日,OpenAI 接连发布 GPT-4.1、o3 和 o4-mini。

GPT-4.1 系列包含了三个模型,分别是 GPT-4.1、GPT-4.1 mini 和 GPT-4.1 nano,它们仅通过 API 调用,并已向所有开发者开放。

OpenAI 表示,GPT-4.1 系列的三个模型的性能全面超越了 GPT-4o 和 GPT-4o mini,并在编程和指令遵循方面均有显著提升。它们还拥有更大的上下文窗口 —— 支持高达 100 万 token 上下文 ,并且能够通过改进的长上下文理解更好地利用这些上下文。知识截止日期已更新至 2024 年 6 月。

总的来说,GPT-4.1 在以下行业标准指标上表现出色:

编程:GPT-4.1 在 SWE-bench Verified 测试中得分为 54.6%,比 GPT-4o 提升 21.4%,比 GPT-4.5 提升 26.6%,使其成为领先的编程模型。

指令遵循:在 Scale 的 MultiChallenge 基准测试(衡量指令遵循能力的指标)中,GPT-4.1 得分为 38.3%,比 GPT-4o 提升了 10.5%。

长上下文:在多模态长上下文理解基准测试 Video-MME 中,GPT-4.1 创下了新的最高纪录 —— 在长篇无字幕测试中得分为 72.0%,比 GPT-4o 提升了 6.7%。

OpenAI 表示,o3 是他们目前最强大的推理模型,在编程、数学、科学、视觉感知等多个维度的基准测试中都刷新了 SOTA,在分析图像、图表和图形等视觉任务中表现尤为出色。

o4-mini 是一款小型模型,专为快速、经济高效的推理而优化,它以其尺寸和成本实现了卓越的性能,尤其是在数学、编程和视觉任务方面。

o4-mini 是 AIME 2024 和 2025 基准测试中表现最佳的模型。在专家评估中,它在非 STEM 任务以及数据科学等领域的表现也优于其前身 o3-mini。得益于其高效性,o4-mini 支持的使用限制远高于 o3,使其成为解决需要推理能力的问题的强大高容量、高吞吐量解决方案。

此外,OpenAI 再次开源了!发布一款本地代码智能体 Codex CLI,可将自然语言转化为可运行的代码,兼容所有 OpenAI 模型,包括刚刚发布的 o3、o4-mini 和 GPT-4.1。

学术研究

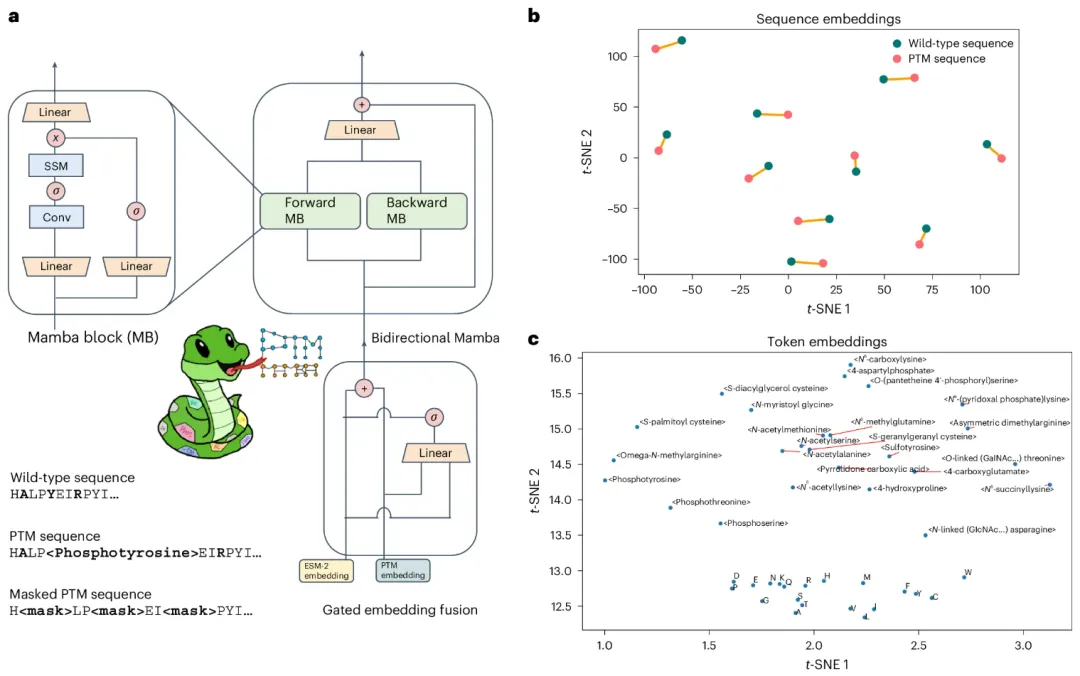

西湖大学团队开发PTM感知蛋白质语言模型,登Nature子刊

近日,杜克大学、西湖大学的研究人员开发了一种翻译后修饰 (PTM)感知蛋白质语言模型(LM)——PTM-Mamba,它通过一种新开发的门控机制,使用双向 Mamba 块将 PTM token 与 ESM-2 蛋白质 LM 嵌入融合。

PTM-Mamba 能够独特地同时建模野生型和 PTM 序列,从而支持下游任务,例如疾病关联和药物可药性预测、PTM 对蛋白质相互作用的影响预测以及零样本 PTM 发现。

该研究将 PTM-Mamba 确立为 PTM 感知蛋白质建模和设计的基础工具。

图示:TM-Mamba 的架构和嵌入可视化

研究人员整理了一个包含 79,707 个修饰序列的训练数据集,该数据集由 Swiss-Prot 数据库中 311,350 条经实验验证的 PTM 记录构建而成。

他们专门将 PTM 注释映射到各自的蛋白质序列,确保 PTM 类型和序列长度的多样化表示。

研究提出的 PTM 蛋白质语言模型基于 Mamba,这是一个结构化的状态空间模型,通过选择性状态空间架构提供计算效率和灵活性,该架构在序列长度方面实现了亚二次时间和内存复杂度。此外,Mamba 使用硬件感知原语(例如并行化状态转换和卷积投影)来加速计算,而不会影响扩展。

该团队在三个明确利用 PTM 标记化的基准测试任务上对 PTM-Mamba 进行了评估:疾病关联预测、成药性预测以及 PTM 对蛋白质-蛋白质相互作用 (PPI) 的影响。

图示:PTM-Mamba 在各种 PTM 相关任务中的性能评估

该研究以「PTM-Mamba: a PTM-aware protein language model with bidirectional gated Mamba blocks」为题,发布在《Nature Methods》。

AI攻克50年数学难题!o3-mini-high完成数学证明

AI完成了数学界50年没有解决的数学证明!

完成这项研究的,是美国纽约布鲁克海文国家实验室凝聚态物理与材料科学分部的一位华人学者Weiguo Yin。

在这项研究中,作者在一维J1-J2 q态Potts模型,通过引入最大对称子空间(MSS)方法,对其精确求解。

具体来说,作者将q^2×q^2的传递矩阵进行块对角化。

而q=3的情况,正是基于OpenAI的最新推理模型o3-mini-high来精确求解的。

在AI的帮助下,研究者成功证明,模型可以映射为一维q态Potts模型,其中J2作为最近邻相互作用,J1则作为有效的磁场,这一结果扩展了之前在q=2,即Ising模型的证明。

注意,这个问题,在数学界有50年没有解决。

论文引用了关于J1−J2伊辛模型(即q=2的Potts模型)的工作,这些工作可以追溯到1969年和1970年。

而o3-mini-high帮忙完成的这项证明,为众多悬而未决的物理问题(层状材料中原子或电子顺序堆叠的问题,以及非常规超导体中常见的T_c-拱形相的形成等),提供了全新的见解。

产品推荐

-

Skywork-OR1-7B-Preview

昆仑万维推理模型Skywork-OR1上线,数学和编程SOTA

-

Skywork-OR1-32B-Preview

昆仑万维推理模型Skywork-OR1上线超算互联网,支持下载模型文件快速开发

-

GLM-4-32B-0414

智谱GLM模型系列上线,32B性能比肩DeepSeek-R1

-

GLM-Z1-9B-0414

智谱 GLM 模型系列迎来新成员:32B/9B 系列 GLM 模型正式开源

-

GLM-Z1-32B-0414

GLM-Z1-32B-0414 是一款具备深度思考能力的推理模型

-

GLM-Z1-Rumination-32B-0414

沉思模型 GLM-Z1-Rumination-32B-0414 代表了智谱对 AGI 未来形态的下一步探索

-

GLM-4-9B-0414

GLM-Z1-9B-0414 在数学推理及通用任务上表现出色

-

GLM-4-32B-Base-0414

GLM 家族迎来新一代开源模型 GLM-4-32B-0414 系列,320 亿参数

-

InternVL3

多模态大模型InternVL3系列上线,可同时处理文字、图片、视频等

-

DeepCoder-14B-Preview

代码推理模型DeepCoder-14B-Preview上线, 媲美o3-mini

-

HiDream-I1-Full

文生图开源模型HiDream-I1-Full上线,几秒生成高质量图像

-

最佳实践Vol.35 | Wan2.1-ComfyUI实操:玩转AI视频,让文字、图片一键动起来

本次实操,我们演示如何在超算互联网启动Wan2.1-ComfyUI模型镜像,带你零门槛解锁AI视频,让文字、图片一键动起来。

-

超算互联网“VASP研习社”上线

面向高校、科研院所等熟悉VASP软件的科研人员,征集基于VASP的高效工作流、方法创新等实战经验。现金奖励+算力券等你来赢!

往期周报

-

2025-04-18

超算&AI应用周报Vol.52 | 视觉语言模型Kimi-VL、开源扩散语言模型Dream 7B上线

-

2025-01-25

超算&AI应用周报 Vol.51 | 超算互联网上线MCP服务,快速获取SCNet最新内容信息

-

2025-03-28

超算&AI应用周报 Vol.50 | 万相Wan2.1 ComfyUI、视频生成模型Open-Sora 2.0上线

-

2025-03-28

超算&AI应用周报 Vol.49 | 谷歌Gemma 3全家桶、OpenAI Agents SDK上线

-

2025-03-07

超算&AI应用周报 Vol.48 | 阿里QwQ-32B API接口服务、智谱文生图模型CogView4上线

-

2025-02-27

超算&AI应用周报 Vol.47 | DeepSeek 8款开源项目、阶跃星辰多模态大模型上线

-

2025-02-21

超算&AI应用周报 Vol.46 | DeepSeek-R1 API接口服务、镜像部署API教程上线,Grok-3发布

-

2025-02-14

超算&AI应用周报 Vol.45 | DeepSeek-R1满血版、部署教程上线!Qwen2.5-Max、字节Goku发布

津公网安备12011602300273号

津公网安备12011602300273号

电子营业执照

电子营业执照

微信服务号

微信服务号