人工智能服务

>

最佳实践

>

DeepSeek-R1模型镜像部署API

为满足企业、开发者对模型定制化部署的需求,提供高效、灵活、稳定的AI推理服务,近日,超算互联网平台上线DeepSeeK-R1模型镜像,支持部署线上API服务,助力用户快速实现AI应用落地。

本次实操,我们以DeepSeek-R1-Distill-8B模型镜像为例,手把手分享如何在超算互联网搭建线上API。

注:DeepSeek-R1(1.5B、8B、70B、671B)支持快速部署API服务;DeepSeek-R1(7B、14B、32B)支持部署AI Web应用。请按需选择镜像。

准备好开启你的专属DeepSeek-R1之旅了吗?跟随我们的步骤,轻松部署。

第一步:创建Notebook在线启动异构加速卡模型镜像

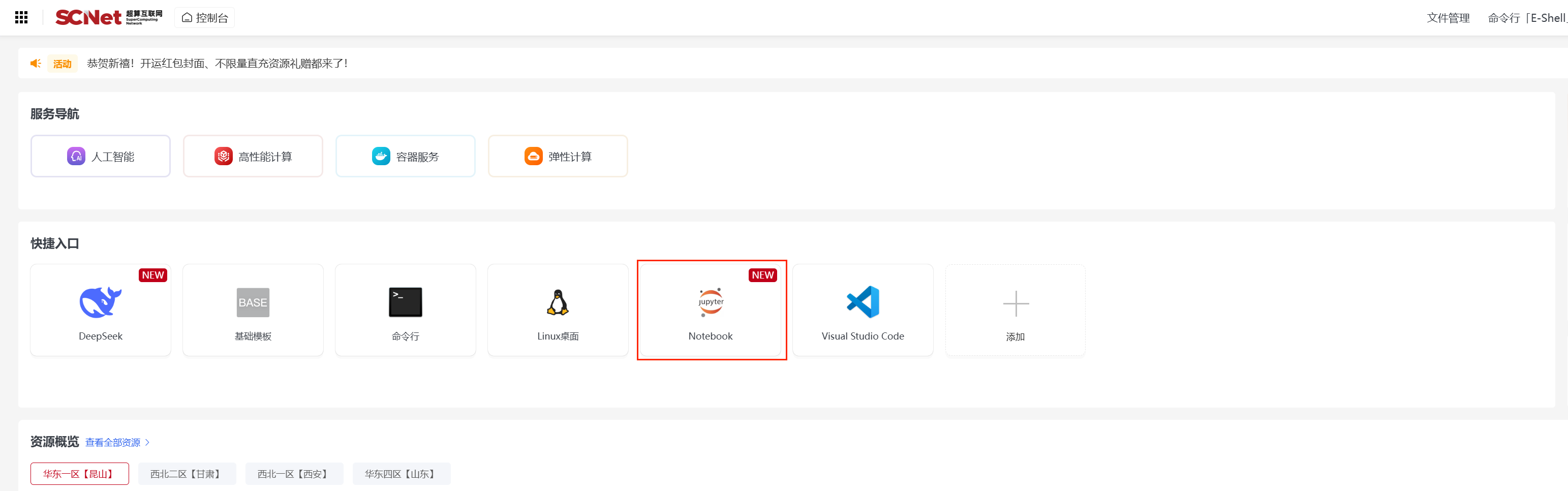

登录超算互联网https://www.scnet.cn个人账号,点击右上角“控制台”;  点击快捷入口中的“Notebook”,进入创建Notebook页面;

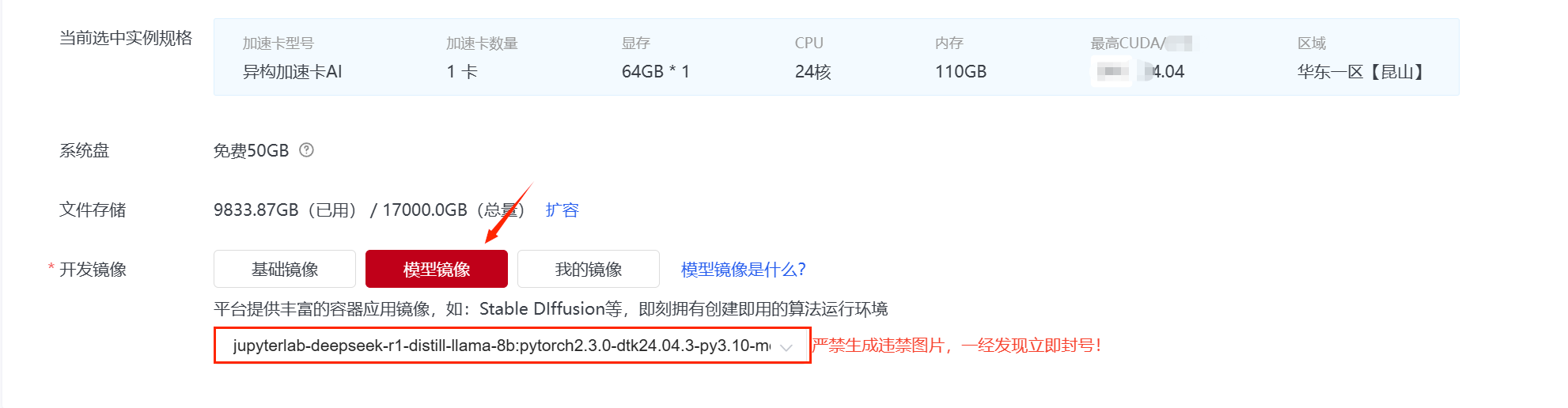

点击快捷入口中的“Notebook”,进入创建Notebook页面;  选择区域、选择异构加速卡AI-64GB,点击“模型镜像”,在列表中选择jupyterlab-deepseek-r1-distill-llama-8b点击创建;

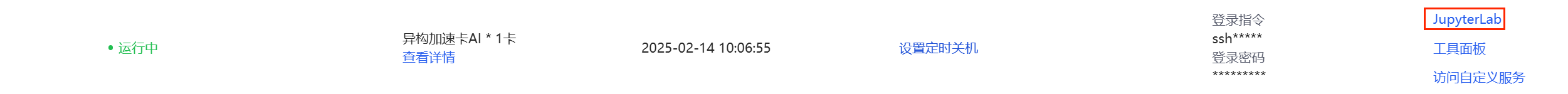

选择区域、选择异构加速卡AI-64GB,点击“模型镜像”,在列表中选择jupyterlab-deepseek-r1-distill-llama-8b点击创建;  创建成功后,点击“JupyterLab”进入Notebook页面;

创建成功后,点击“JupyterLab”进入Notebook页面;

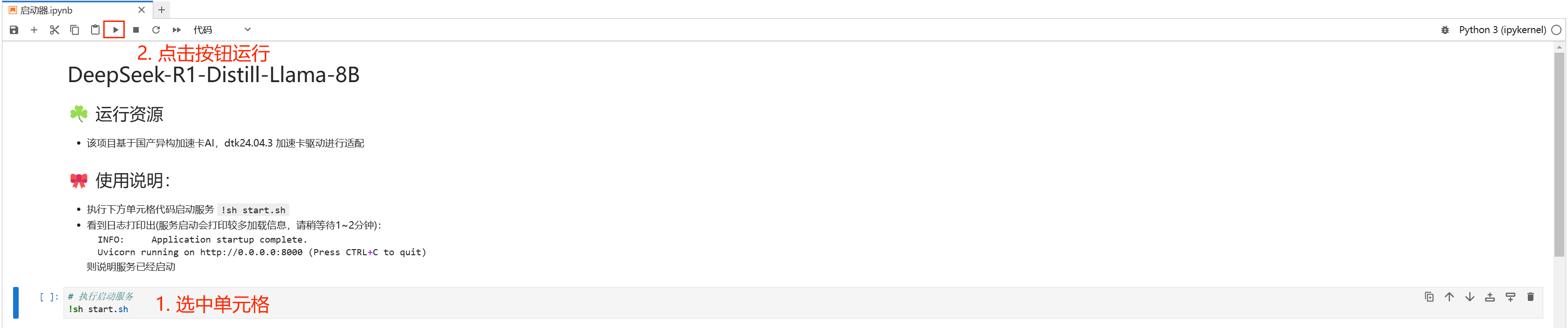

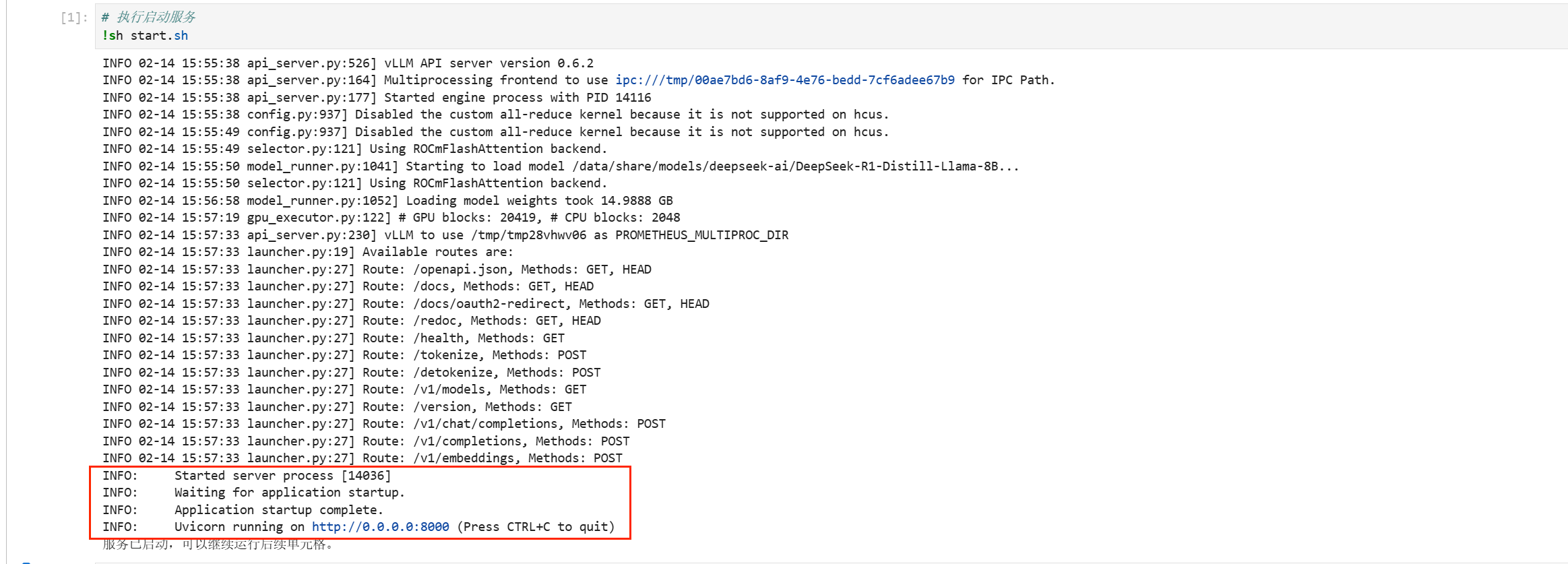

在Notebook中选中单元格,点击按钮运行代码,启动服务。  等待日志打印出端口号(服务启动会打印较多加载信息,请稍等待1~2分钟),当单元格下方出现端口链接时,则说明服务已经启动,复制端口号。

等待日志打印出端口号(服务启动会打印较多加载信息,请稍等待1~2分钟),当单元格下方出现端口链接时,则说明服务已经启动,复制端口号。

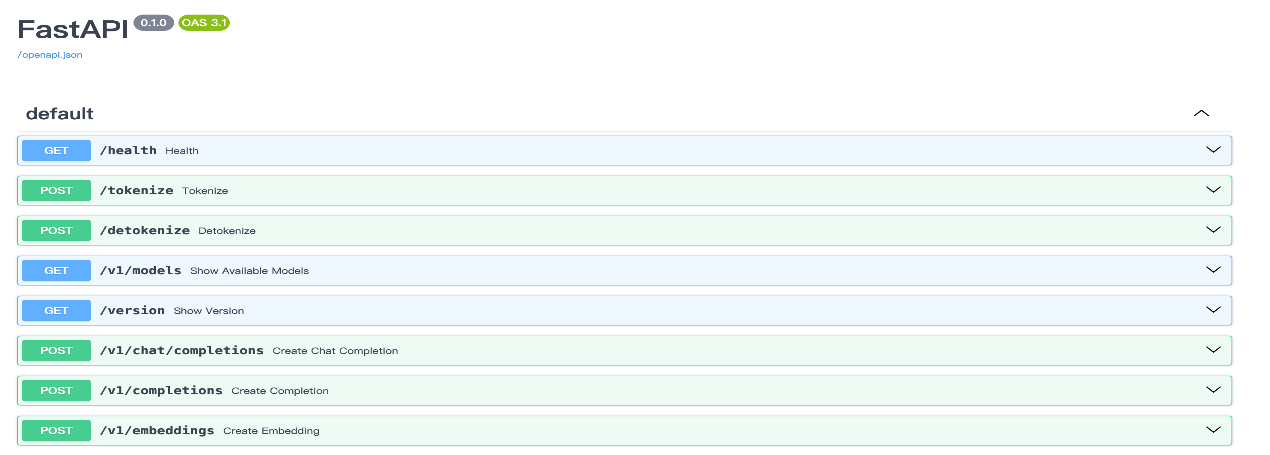

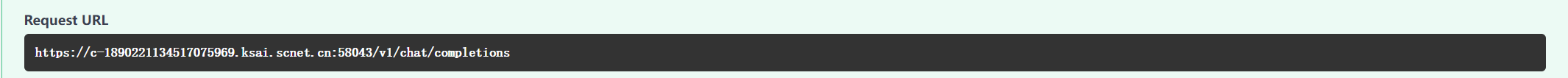

完整的请求地址:见FastAPI页面的Request URL  本次实操通过三种方式访问API:

本次实操通过三种方式访问API:

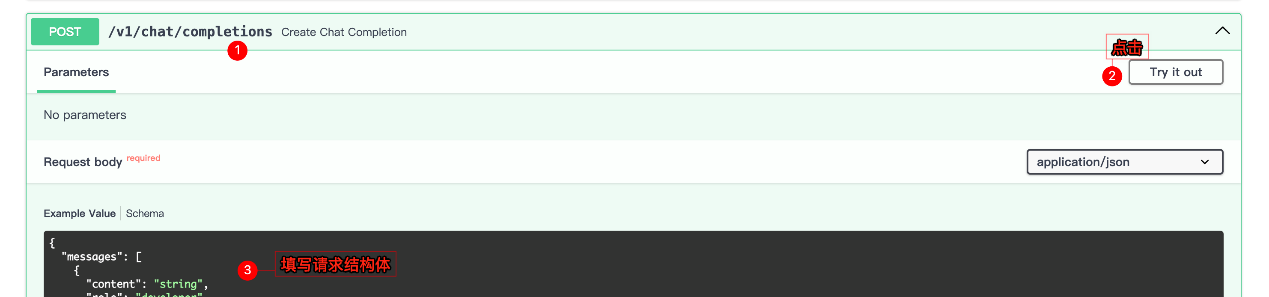

点击地址后,随后点击Try it out,填写请求结构体  请求体示例:

请求体示例:

{

"messages": [

{

"role": "system",

"content": "你是一位知识丰富、友好的助手,可以帮用户解答各方面的知识和问题。请提供清晰、准确和简短的答案。保持回应礼貌、吸引人、切中要害。",

"name": "system"

},

{

"role": "user",

"content": "请问1.25和1.1哪个更大,请说明理由",

"name": "user"

}

],

"model": "/root/DeepSeek-R1-Distill-Llama-8B",

"temperature": 0.1,

"top_p": 0.9,

"max_tokens": 1024

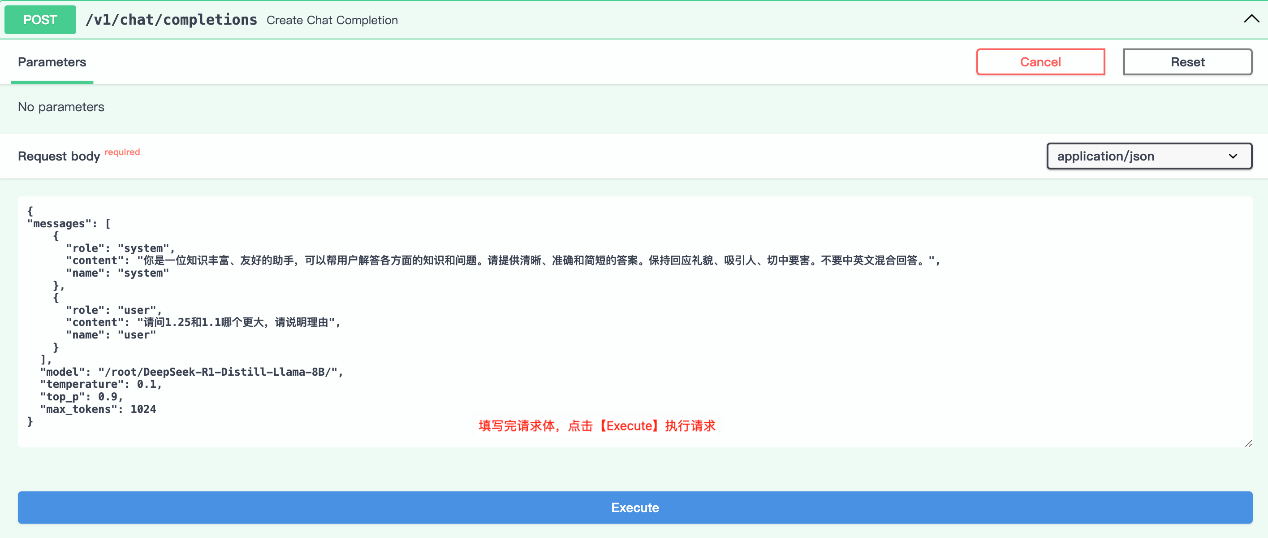

}点击Execute,发送请求  等待请求返回:

等待请求返回:

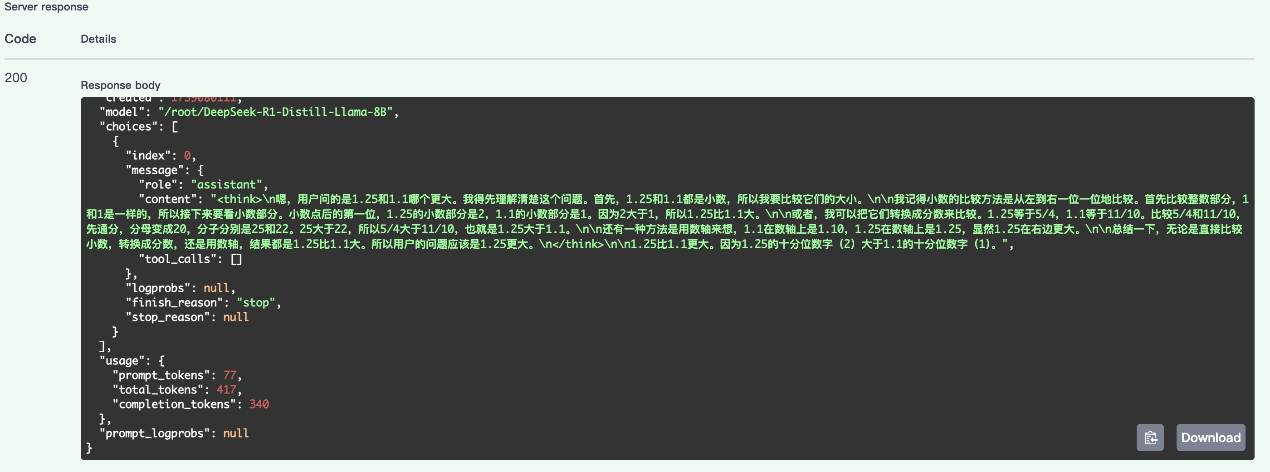

在自己的设备上下载并安装postman软件。

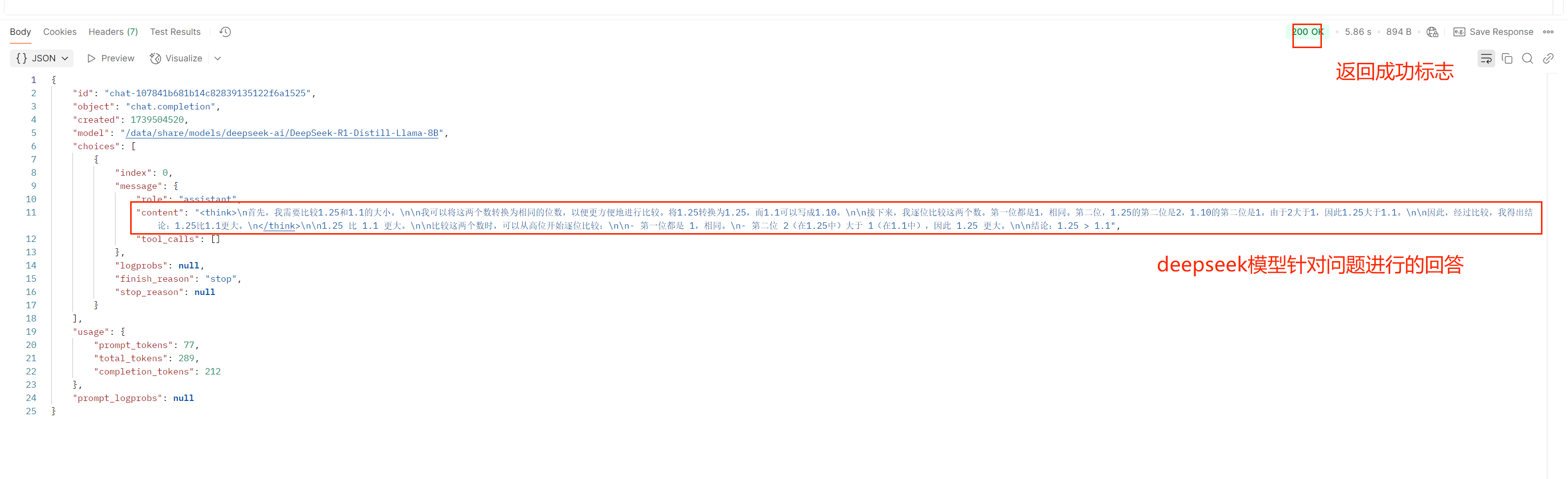

填入完整的请求地址,并填写请求结构体,点击send发送请求  等待请求返回:

等待请求返回:

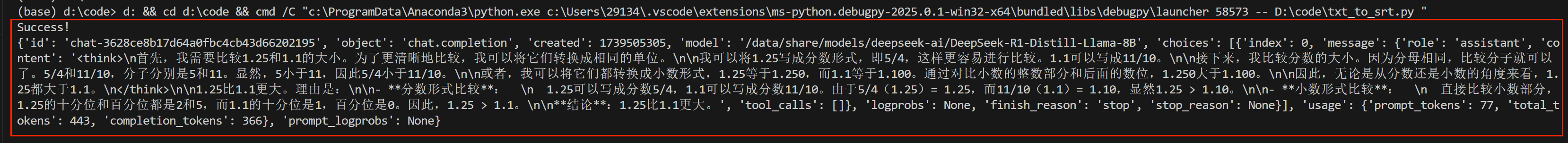

自行配置python环境,安装requests库,编写代码进行访问  在终端即可看到请求返回的结果。

在终端即可看到请求返回的结果。

以上就是本次实操教程的全部内容了,大家可参照此步骤,在超算互联网使用DeepSeek-R1模型镜像部署你的专属线上API。

希望本篇最佳实践为您提供一些有价值的信息和实践技巧。